YES24 카테고리 리스트

YES24 유틸메뉴

- Global YES24안내보기

-

Global YES24는?

K-POP/K-Drama 관련상품(음반,도서,DVD)을

영문/중문 으로 이용하실 수 있습니다.Korean wave shopping mall, sell the

English

K-POP/K-Drama (CD,DVD,Blu-ray,Book) We aceept PayPal/UnionPay/Alipay

and support English/Chinese Language service作为出售正规 K-POP/K-Drama 相关(CD,图书,DVD) 韩流商品的网站, 支持 中文/英文 等海外结账方式

中文Exclusive ticket sales for domestic and international pop artists

Global yesticket

어깨배너

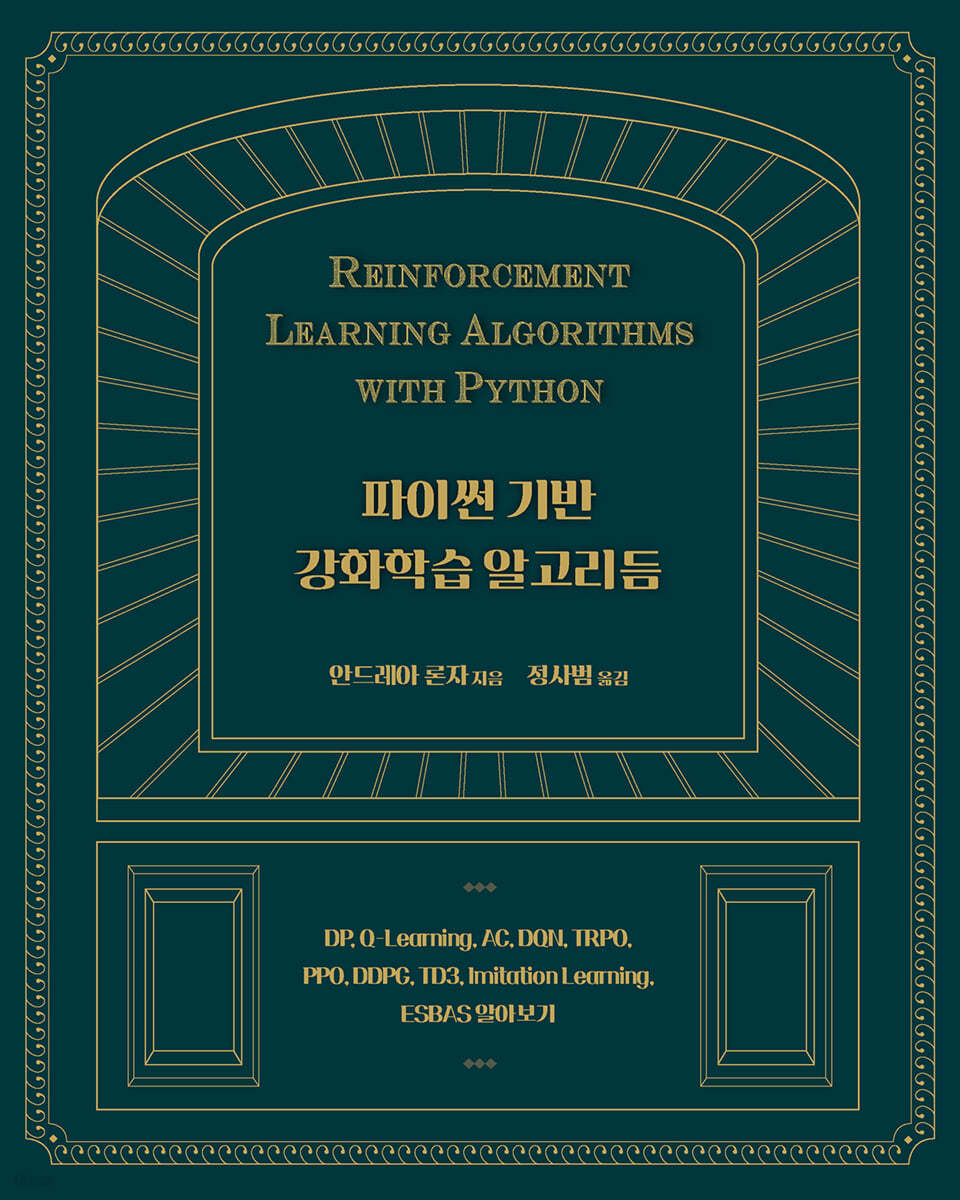

파이썬 기반 강화학습 알고리듬

DP, Q-Learning, AC, DQN, TRPO, PPO, DDPG, TD3, Imitation Learning, ESBAS 알아보기

| 정가 | 30,000원 |

|---|---|

| 판매가 | 27,000원 (10% 할인) |

| YES포인트 |

|

| 결제혜택 | 카드/간편결제 혜택을 확인하세요 카드/간편결제 혜택 보기/감추기 |

|---|

| 구매 시 참고사항 |

|

|---|

- 국내배송만 가능

- 최저가 보상

- 문화비소득공제 신청가능

품목정보

| 발행일 | 2021년 08월 25일 |

|---|---|

| 쪽수, 무게, 크기 | 448쪽 | 188*235*30mm |

| ISBN13 | 9791161755571 |

| ISBN10 | 1161755578 |

관련분류

이 상품의 이벤트 (6개)

-

얼리리더를 위한 7월의 책 : 곰돌이 푸_마그넷 오프너 증정

2024년 07월 01일 ~ 2024년 07월 31일

-

상시

책소개

- 책의 일부 내용을 미리 읽어보실 수 있습니다. 미리보기

목차

출판사 리뷰

회원리뷰 (0건)

매주 10건의 우수리뷰를 선정하여 YES포인트 3만원을 드립니다.3,000원 이상 구매 후 리뷰 작성 시 일반회원 300원, 마니아회원 600원의 YES포인트를 드립니다.

eBook은 다운로드 후 작성한 리뷰만 YES포인트 지급됩니다.

클래스, CD/LP, DVD/Blu-ray, 패션 및 판매금지 상품, 예스24 앱스토어 상품 제외됩니다. 리뷰/한줄평 정책 자세히 보기 리뷰쓰기

등록된 리뷰가 없습니다.

첫번째 리뷰어가 되어주세요.

한줄평 (0건)

1,000원 이상 구매 후 한줄평 작성 시 일반회원 50원, 마니아회원 100원의 YES포인트를 드립니다.eBook은 다운로드 후 작성한 리뷰만 YES포인트 지급됩니다.

클래스, CD/LP, DVD/Blu-ray, 패션 및 판매금지 상품, 예스24 앱스토어 상품 제외됩니다. 리뷰/한줄평 정책 자세히 보기

등록된 한줄평이 없습니다.

첫번째 한줄평을 남겨주세요.

배송/반품/교환 안내

배송 안내

| 배송 구분 |

예스24 배송

|

|---|---|

| 포장 안내 |

안전하고 정확한 포장을 위해 CCTV를 설치하여 운영하고 있습니다. 고객님께 배송되는 모든 상품을 CCTV로 녹화하고 있으며, 철저한 모니터링을 통해 작업 과정에 문제가 없도록 최선을 다 하겠습니다.

목적 : 안전한 포장 관리 |

반품/교환 안내

※ 상품 설명에 반품/교환과 관련한 안내가 있는경우 아래 내용보다 우선합니다. (업체 사정에 따라 달라질 수 있습니다)

| 반품/교환 방법 |

|

|---|---|

| 반품/교환 가능기간 |

|

| 반품/교환 비용 |

|

| 반품/교환 불가사유 |

|

| 소비자 피해보상 |

|

| 환불 지연에 따른 배상 |

|

.jpg)

.jpg)

.jpg)

![예스24 X JTBC <소탐대실> 콜라보 [서탐대실]](http://image.yes24.com/images/00_Event/2023/0921Youtube/bn_mobile_720x360.jpg)